人工智能导论考试预测

演绎推理※23

- 一般到个别

归纳推理

- 个别到一般

- 完全归纳推理和不完全归纳推理

默认推理

- 缺省推理,假设某些知识已经具备

确定性推理

- 知识证据确定,结论也确定

不确定性推理※22

- 推理时所用的知识与证据不都是确定的,推出的结论也是不确定的。

单调推理

- 随推理深入,越来越接近目标

非单调推理

- 由于新知识加入,反而要否定已有结论,使推理返回到某一步重新开始

启发式推理

- 启发性知识:与问题有关且能加快推理过程、提高搜索效率的知识。

↓

正向推理

- 已知事实→结论

- 从初始已知事实出发,在知识库KB中找出当前可适用的知识,构成可适用知识集KS。

- 按某种冲突消解策略从KS中选出一条知识进行推理,并将推出的新事实加入到数据库DB中作为下一步推理的已知事实,再在KB中选取可适用知识构成KS。

- 重复(2),直到求得问题的解或KB中再无可适用的知识

逆向推理

- 以某个假设目标作为出发点

- 寻找证明这个目标的证据,若都能找到,则假设成立;若找不到则换假设目标

混合推理

- 先正向后逆向

- 先逆向后正向

双向推理

- 正逆同时进行,在推理过程中的某一步“碰头”

↑

信任函数和似然函数区别和联系※2022

盲目搜索※2023

- 在不具有对特定问题的任何有关信息的条件下,按固定的步骤(依次或随机调用操作算子)进行的搜索。

启发式搜索

- 考虑特定问题领域可应用的知识,动态地确定调用操作算子的步骤,优先选择较适合的操作算子,尽量减少不必要的搜索,以求尽快地到达结束状态。

状态空间搜索※2022

- 状态空间:利用状态变量和操作符号,表示系统或问题的有关知识的符号体系

- 利用状态空间进行搜索,得出一个从初始状态到目标状态的路径

带回溯策略的搜索※2023

- 从初始状态出发,不停地、试探性地寻找路径,直到它到达目的或“不可解结点”,即“死胡同”为止。

- 若它遇到不可解结点就回溯到路径中最近的父结点上,查看该结点是否还有其他的子结点未被扩展。若有,则沿这些子结点继续搜索;如果找到目标,就成功退出搜索,返回解题路径。

启发式图搜索

- 启发信息:用来简化搜索过程有关具体问题领域的特性的信息叫做启发信息。

- 利用启发信息进行搜索,例如A搜索算法和A*搜索算法

智能计算※2023

- 受自然界和生物界规律的启迪,人们根据其原理模仿设计了许多求解问题的方法,这些算法称为智能计算或计算智能

遗传算法定义

- 一类借鉴生物界自然选择和自然遗传机制的随机搜索算法,非常适用于处理传统搜索方法难以解决的复杂和非线性优化问题。

遗传算法的基本思想※2022

在求解问题时从多个解开始,然后通过一定的法则进行逐步迭代以产生新的解。

双倍体遗传算法※2023

- 采用显性和隐性两个染色体同时进行进化,提供了一种记忆以前有用的基因块的功能。

多种群遗传算法

- 建立两个遗传算法群体,分别独立地运行复制、交叉、变异操作,同时当每一代运行结束以后,选择两个种群中的随机个体及最优个体分别交换。

自适应遗传算法

- 当种群各个体适应度趋于一致或者趋于局部最优时,使$P_c、P_m$增加,以跳出局部最优;而当群体适应度比较分散时,使$P_c、P_m$减少,以利于优良个体的生存。

群智能算法

- 受动物群体智能启发的算法。

- 群体智能:简单个体组成的群落与环境以及个体之间的交互行为

粒子群优化算法基本思想※2023

- 将每个个体看作n维搜索空间中一个没有体积质量的粒子,在搜索空间中以一定的速度飞行,该速度决定粒子飞行的方向和距离。所有粒子有一个由优化函数决定的适应值。

蚁群算法基本思想

- 信息素跟踪:按照一定的概率沿着信息素较强的路径觅食。

- 信息素遗留:会在走过的路上会释放信息素,使得在一定的范围内的其他蚂蚁能够觉察到并由此影响它们的行为。

专家系统定义※2023

- 一类包含知识和推理的智能计算机程序。

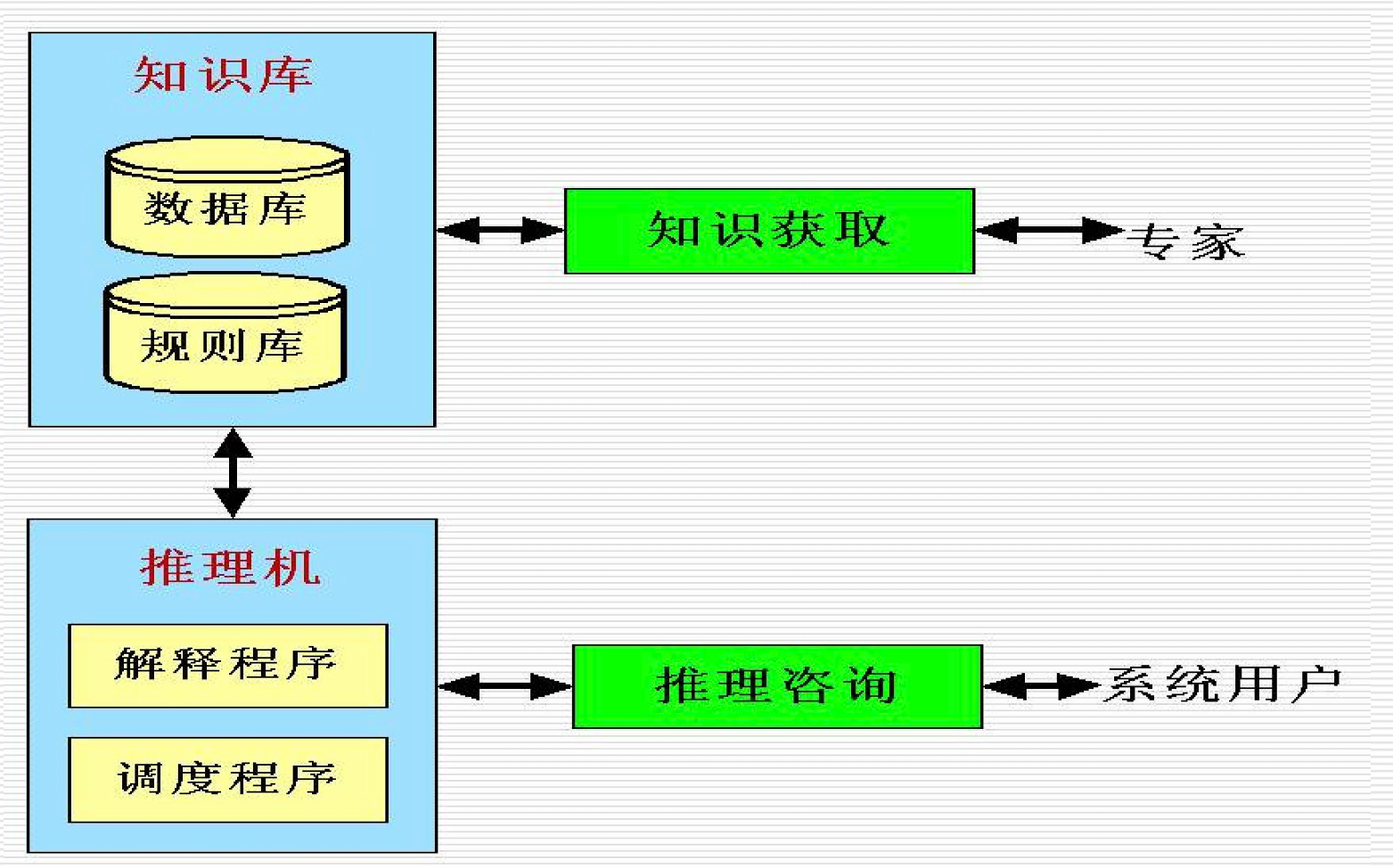

专家系统的基本结构,并解释其核心部件的功能※2022

- 知识库:存储专家的知识和经验,通常以规则、事实和关系的形式表示。

- 推理机:利用知识库中的知识进行推理和决策,模拟专家的思维过程。

机器学习概念※2023

- 机器学习(Machine learning)使计算机能模拟人的学习行为,自动地通过学习来获取知识和技能,不断改善性能,实现自我完善。

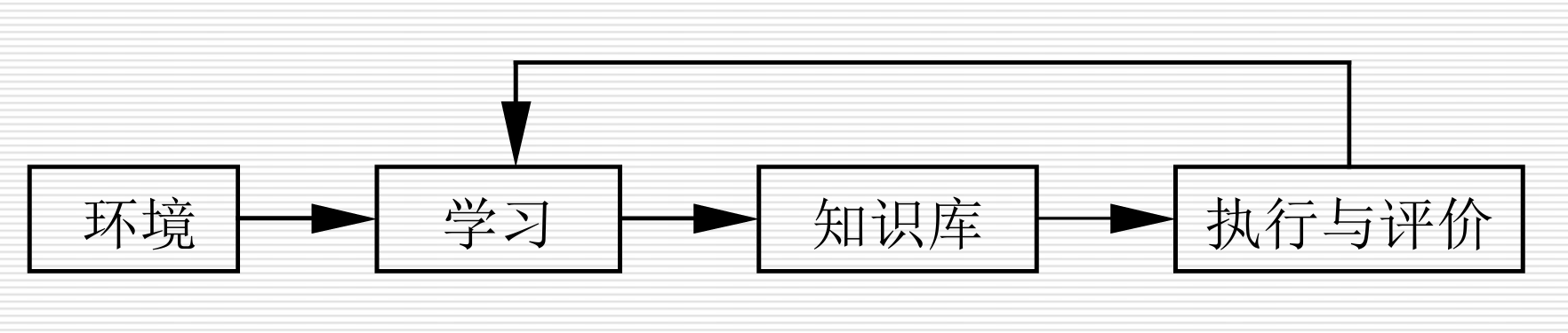

学习系统基本结构※2023

知识发现※2023

- 从数据库中发现知识(KDD)。

数据挖掘※2022

- 是从数据库中挖掘知识。

BP神经网络

初始化权重和偏置:在开始训练之前,随机初始化网络中的权重和偏置。

前向传播:输入数据通过网络层层传播,最终得到输出。

计算误差:比较输出结果与实际结果,计算误差。

反向传播:通过误差反向传播算法,计算每个权重和偏置的梯度。

更新权重和偏置:根据计算出的梯度,更新权重和偏置,以减小误差。

重复上述步骤:直到网络收敛,即误差达到预定阈值或达到最大迭代次数。

卷积

卷积操作的目的是从输入图像中提取特征。具体而言,卷积层通过卷积核(也称为滤波器)对输入进行卷积操作,生成特征图(feature map)。卷积操作的步骤如下:

选择卷积核:卷积核是一个小矩阵,用来扫描输入图像的不同区域。

局部加权求和:将卷积核与图像的局部区域进行加权求和,即点积运算。

生成特征图:将结果赋值到特征图的对应位置,并继续扫描下一位置。

卷积核可以帮助检测图像中的边缘、纹理、颜色等低级特征,逐层堆叠后可提取更高级别的特征。

池化

池化操作的目的是减少特征图的尺寸,同时保留重要信息,从而减少计算量和防止过拟合。常见的池化操作有两种:最大池化(Max Pooling)和平均池化(Average Pooling)。

最大池化:在局部区域内选择最大值作为输出。最大池化可以提取最显著的特征,增强模型的鲁棒性。

平均池化:在局部区域内计算平均值作为输出。平均池化则较平滑特征图,减少过拟合。

通过卷积和池化操作,卷积神经网络可以逐步提取输入图像的特征,并进行分类或回归等任务。

生成式对抗网络

GAN的基本思想是通过两个神经网络相互对抗来生成新的、与原始数据类似的数据。具体来说,它由两个主要部分组成:

生成器(Generator):负责生成类似于真实数据的假数据。生成器接受一些随机噪声作为输入,并将其转换为数据(例如图片、文本等)。

判别器(Discriminator):负责区分真实数据和生成器生成的假数据。判别器的输入是一个数据样本,并输出一个概率,表示该样本是否为真实数据。

在训练过程中,生成器和判别器通过博弈论中的零和博弈不断提升自己的能力。生成器试图生成尽可能真实的假数据,而判别器则不断提高识别真假数据的能力。最终,生成器生成的数据将会非常逼真,难以被判别器识别出来。